1. Mises à jour de l’algorithme

Google ne cache pas le fait qu’il publie plusieurs mises à jour tout au long de l’année, certaines plus importantes que d’autres. Malheureusement, essayer d’obtenir des détails solides sur les changements revient franchement à essayer d’obtenir du sang d’une pierre.

Cependant, un moyen simple d’évaluer si votre site peut avoir été impacté par une mise à jour de l’algorithme est de garder un œil attentif sur les modifications confirmées par Google lui-même.

Mais, de loin, le moyen le plus simple d’obtenir des informations sur les changements d’algorithme est d’utiliser des outils tels que Mozcast – de Moz.com et le capteur SEMrush de SEMrush. Si aucun de ceux-ci ne vous plaît, Algoroo est un autre outil de suivi d’algorithme disponible gratuitement.

Si vous constatez qu’il y a en fait eu une mise à jour récente, je vous recommande fortement de passer un peu de temps à analyser les sites qui ont été les plus touchés. Essayez de repérer toute corrélation entre eux et assurez-vous que votre site ne subit pas le même sort.

2. Erreurs de suivi

Même maintenant, je suis étonné du nombre de webmasters et de propriétaires de sites qui parviennent à extraire leurs codes de suivi du site et je me demande pourquoi le trafic chute.

Heureusement, c’est une erreur qui peut être facilement corrigée, mais à long terme, vous manquerez de données – donc plus vite vous le repérerez et le trierez, mieux ce sera !

Si vous remarquez qu’aucune session n’est soudainement enregistrée dans Google Analytics ou qu’une balise ne se déclenche pas, il est probable que les codes de suivi comportent une erreur ou aient été entièrement supprimés. Si vous y avez accès, vérifiez que le code est présent et correct.

Vous pouvez également contacter vos développeurs et confirmer que le code de suivi est là où il doit être et qu’il fonctionne.

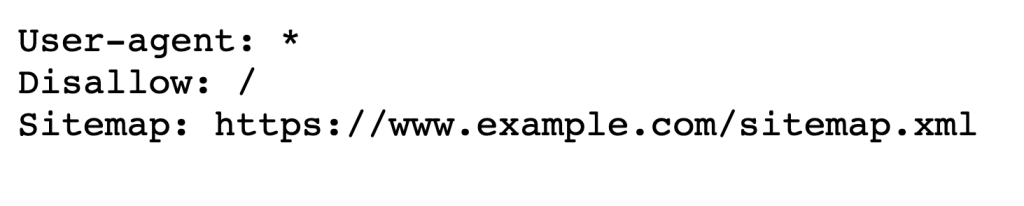

3. Règles robots.txt incorrectes

Êtes-vous sûr que votre site n’empêche pas les moteurs de recherche d’explorer le fichier robots.txt ?

Il n’est pas rare que les développeurs laissent les fichiers robots.txt inchangés après la migration depuis un site Web de développement ou de préproduction. La plupart du temps, lorsque cela se produit, c’est complètement accidentel.

Accédez au fichier robots.txt de votre site et assurez-vous que la règle suivante n’est pas présente :

Si c’est le cas, vous devrez supprimer la règle d’interdiction et soumettre à nouveau votre fichier robots.txt via Google Search Console et le testeur robots.txt

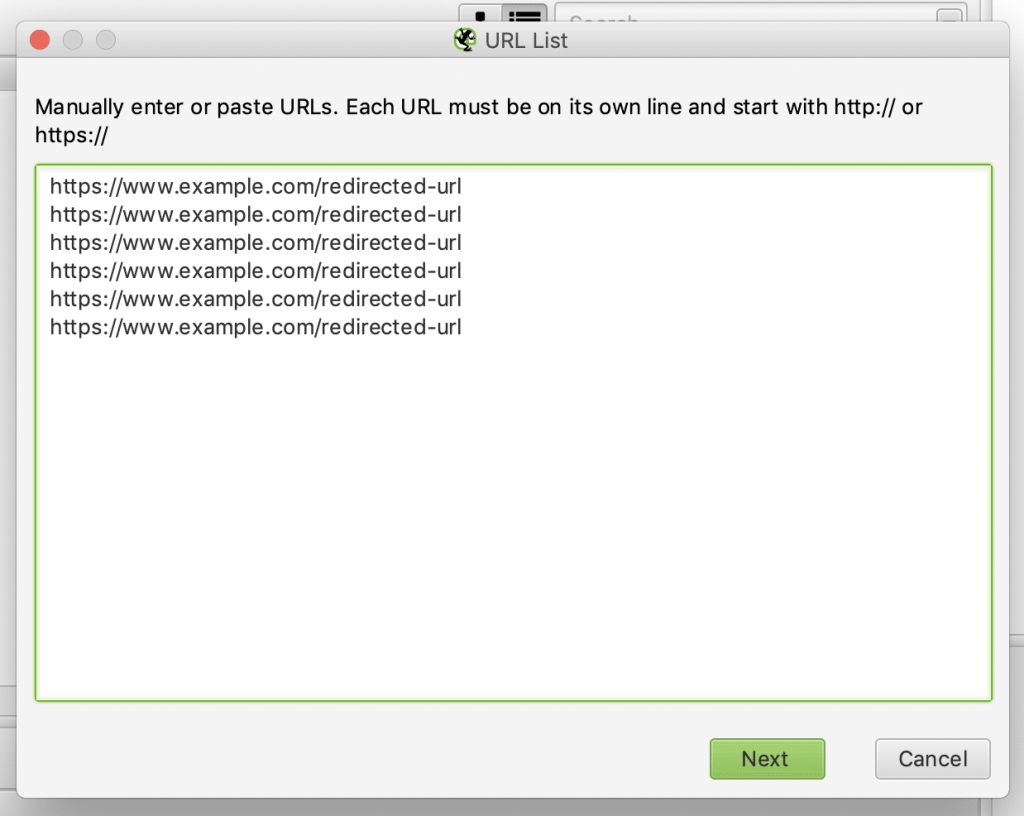

4. Erreurs de redirection

La plupart des sites, en particulier les grands sites Web, auront des redirections en place. Ils sont le plus souvent ajoutés via un fichier .htaccess, ou si vous utilisez WordPress, un plugin pour vous faciliter la vie.

Chaque fois que vous ajoutez une nouvelle redirection permanente (301) à votre site, je vous recommande fortement de la tester avant de la pousser vers un environnement en direct, d’autant plus si vous ajoutez de grandes quantités de redirections.

Pour m’assurer que les redirections fonctionnent toujours comme prévu, j’utilise simplement un robot d’exploration Web (ma préférence est Screaming Frog) et en utilisant le mode liste (Mode> Liste), collez ma liste d’URL qui sont redirigées et explorez-les , puis analysez les codes de réponse et les destinations finales :

5. Erreurs d’exploration

À l’aide de la nouvelle console de recherche, ouvrez le rapport de couverture de l’index et recherchez les URL contenant une erreur.

Toutes les URL du rapport de couverture auxquelles une erreur est associée ne seront pas incluses dans l’index. Les erreurs typiques trouvées dans ce rapport incluent :

- Erreurs de serveur

- Erreurs de redirection

- URL bloquées par robots.txt

- URL marquées d’une balise noindex

- Erreurs logicielles 404

- URL renvoyant une demande non autorisée

- URL qui ne peuvent pas être localisées (404)

- Erreurs d’exploration

Vous trouverez plus d’informations sur ces rapports ici.

À lire également : Voice AI: Plongée dans les Fonctionnalités Futures des Applications

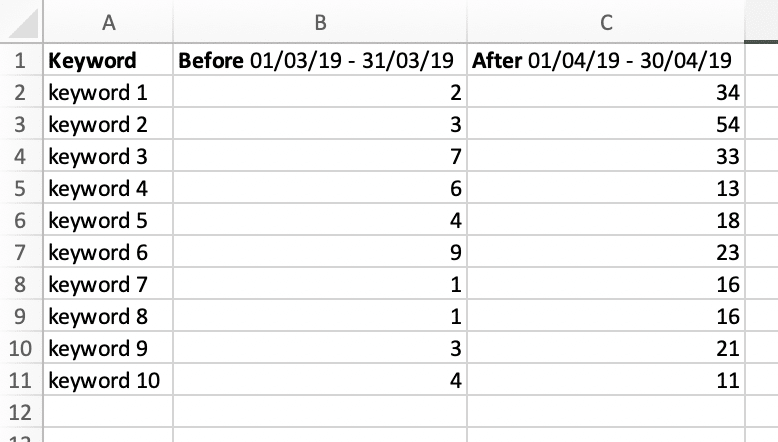

6. Pertes de classement

Une autre raison très courante de la baisse du trafic sur le site Web est due à une perte de classement organique.

Maintenant, si vous suivez vos performances à l’aide d’un tracker de classement, le dépannage sera beaucoup plus facile. Si ce n’est pas le cas, l’utilisation des données de la Search Console sera votre meilleur pari.

J’utilise le processus suivant pour avoir une idée de tout changement de classement :

À l’aide de Google Analytics et de la console de recherche ou de votre outil de suivi de classement préféré (ma préférence est AccuRanker), identifiez le moment où le trafic a commencé à baisser

Faites une exportation des mots-clés de classement avant et après la chute

À l’aide d’Excel ou de G Sheets, créez un tableau et collez les données côte à côte

Comparez l’évolution des positions

Recibler les termes supprimés avec la recherche et la cartographie des mots clés

Alternativement, des outils tels que SISTRIX sont également très utiles pour aider à identifier les mots-clés qui ont chuté de la première page ou même des 100 premiers résultats.

7. Modifications du plan de site XML

Si vous êtes un référenceur, vous saurez (espérons-le) que seules les URL qui renvoient une réponse 200 et qui sont indexables doivent être visibles dans vos sitemaps, à moins que vous n’ayez délibérément laissé des URL redirigées pour vous assurer que les moteurs de recherche les trouvent plus rapidement.

Une des raisons pour lesquelles vous pourriez voir le trafic chuter est un changement dans votre sitemap XML.

Explorez les URL du sitemap et assurez-vous qu’elles renvoient toutes une réponse 200 OK et que toutes les nouvelles pages de destination ou articles sont également inclus. Si votre site contient 200 URL et qu’il n’y en a que 50 dans le sitemap, vous devrez le régénérer et le soumettre à nouveau à l’aide de la Search Console.

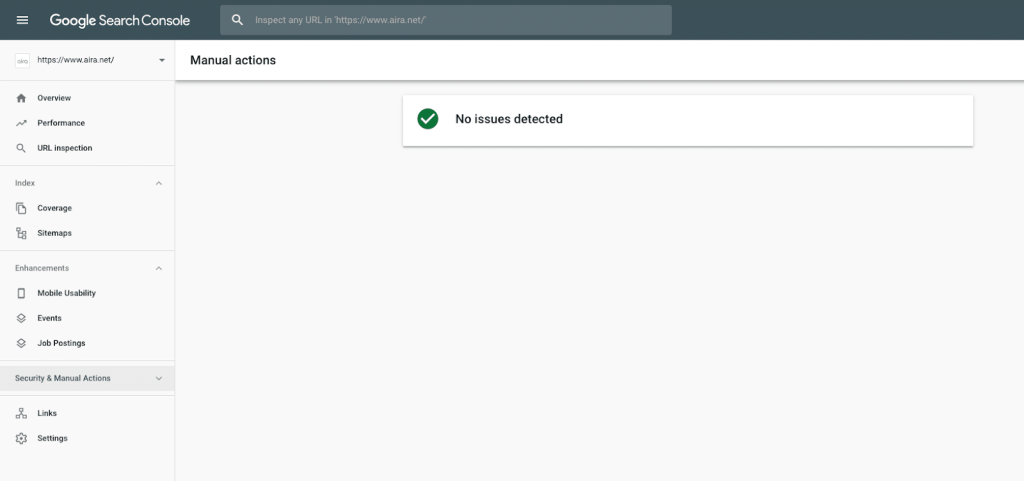

8. Actions manuelles et pénalités

Une action manuelle sera émise contre votre site si l’un des réviseurs humains aux yeux d’aigle trouve du contenu sur le site qui va à l’encontre des directives de Google. Vous pouvez trouver plus d’informations sur leurs directives aux webmasters ici.

Vous pouvez voir si votre site a été affecté par des actions manuelles en utilisant le rapport sur les actions manuelles dans la Search Console.

9. URL désindexées

Google a récemment tweeté à propos d’un bogue de « désindexation » signalé qui faisait que les sites voyaient des pages importantes sembler être supprimées de l’index presque du jour au lendemain. Mais ce n’est pas seulement un problème récent.

Trouver ces URL importantes qui ne sont plus disponibles dans les résultats de recherche peut être un facteur important lors d’une enquête sur une perte soudaine de trafic sur un site Web.

10. Cannibalisation des mots-clés

Si vous avez récemment créé beaucoup de nouveau contenu autour d’un sujet spécifique sans tenir compte du ciblage par mots-clés, vous avez peut-être accidentellement été victime d’un problème de cannibalisation des mots-clés.

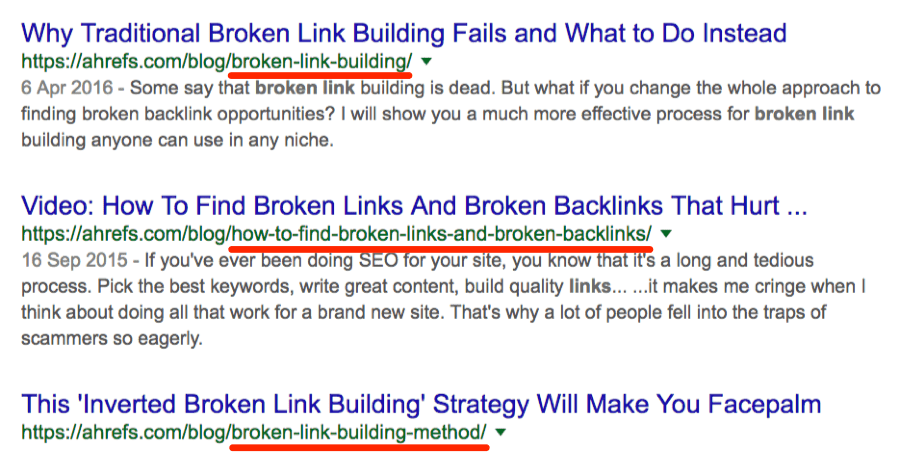

La cannibalisation se produit lorsqu’un site Web apparaît pour un mot-clé avec plusieurs URL. Par exemple, Ahrefs.com a beaucoup de contenu autour de la création de liens brisés :

Source : Hrefs.com

Si le trafic est réparti sur plusieurs pages ou publications, vous risquez de perdre un trafic organique précieux. Le moyen le plus simple que j’ai trouvé pour mettre en évidence les erreurs de cannibalisation a été d’utiliser BigMetrics.io et le rapport de cannibalisation.

Créez simplement un compte (version d’essai ou payante) et connectez-le à votre propriété Search Console et exportez.

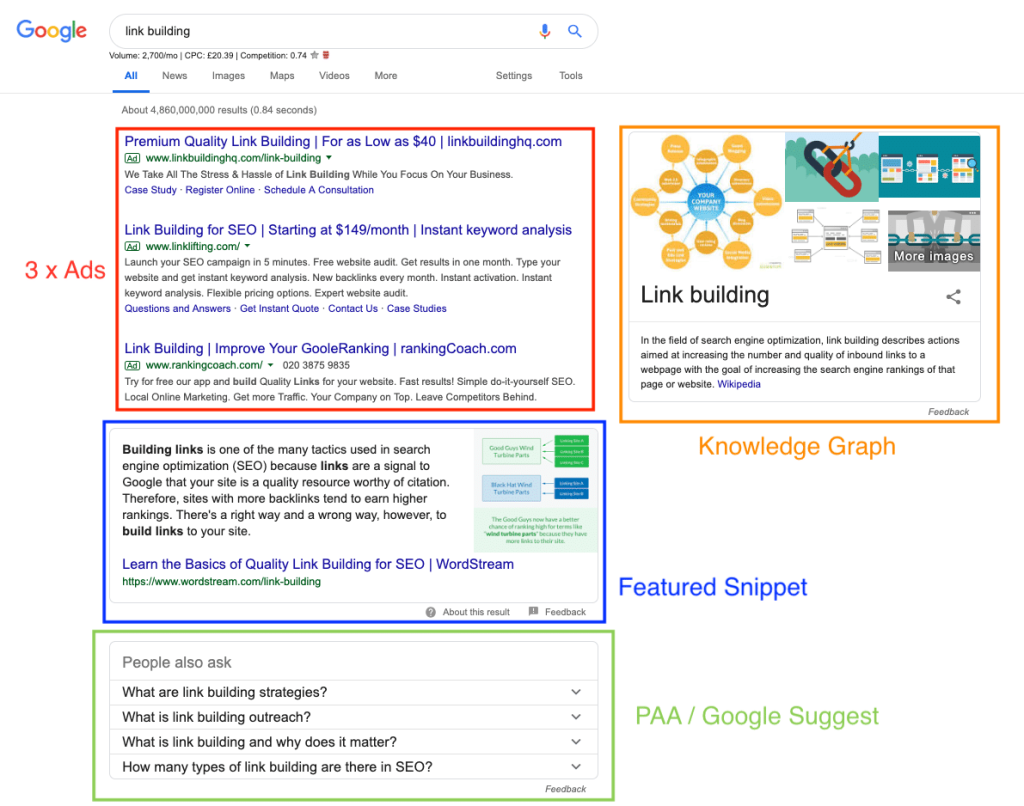

11. Changements de mise en page SERP

Un changement récent dans la façon dont Google et les moteurs de recherche affichent les résultats organiques peut avoir un impact sur vos niveaux de trafic. Donc, vous assurer que vous êtes adaptable et prêt à apporter des changements ira un long chemin.

Google, en particulier, a apporté un certain nombre de modifications à la manière dont les résultats sont affichés ; montrant des extraits en vedette, des graphiques de connaissances et rendant les annonces plus visibles pour n’en nommer que quelques-uns, rendant la vie des agences et des professionnels du référencement très frustrante.

Exemple de mise en page SERP compétitive

Dans la capture d’écran ci-dessus, vous verrez qu’avant de voir le moindre signe de résultat organique, vous devez rivaliser avec les annonces, les graphiques de connaissances, les extraits en vedette et les suggestions de Google. Cela ne prend même pas en considération un certain nombre d’autres fonctionnalités SERP.

Analysez les mots clés que vous ciblez ; Ce n’est pas parce qu’ils ne déclenchaient pas une fonctionnalité SERP qu’ils ne le font pas maintenant. Le vérificateur SERP d’AccuRanker est idéal pour cela.

Si les mots clés que vous ciblez déclenchent des extraits en vedette et des réponses instantanées, et que vous n’êtes pas l’extrait en vedette, vous allez perdre des clics et du trafic vers votre site.

Résumé

Voir une baisse du trafic sur un site Web peut être très décourageant, mais il y a toujours une raison à cela, et s’il y a une raison, elle peut généralement être corrigée.

Si vous retenez une chose de cet article, c’est qu’un déclin soudain pourrait être dû à un certain nombre de raisons combinées, ou même à une seule page clé riche en trafic qui est tombée de l’index.

Assurez-vous d’enquêter sur toutes les pistes possibles, et vous découvrirez rapidement la cause et mettrez en place un plan de récupération.

À lire également : Core Web Vitals : de quoi s’agit-il et pourquoi devriez-vous vous en soucier ?

Laisser un commentaire